Apple 的最新研究揭示了为语音识别制作的模型如何通过处理心音图来确定您的心率,这些图可用于AirPods.

周四,在该公司公布其Humanoid 策略涉及机器人技术的研究,苹果发表探索健康应用的新研究。具体来说,就是心率估计。

在其最新的研究》的标题为“Foundation Model Hidden Representations for Heart Rate Estimation from Auscultation”,该公司的研究人员解释了如何使用基础模型从录音中确定心率,即使它们的创建目的不同。

Apple 测试了六种流行的基础模型,包括 Whisper,它用于音频转录,以确定它们是否可以超出预期目的使用。还测试了内部 CLAP (对比语言-音频预训练) 模型。

基础模型不是录制的语音,而是用于处理心动图记录或心音,总计约 20 小时。

有问题的录音属于公开可用的 CirCor DigiScope Phonocardiogram 数据集,长度从 5.1 秒到 64.5 秒不等。

Apple 使用大约 20 小时的心声图音频文件进行了测试。图片来源: 苹果

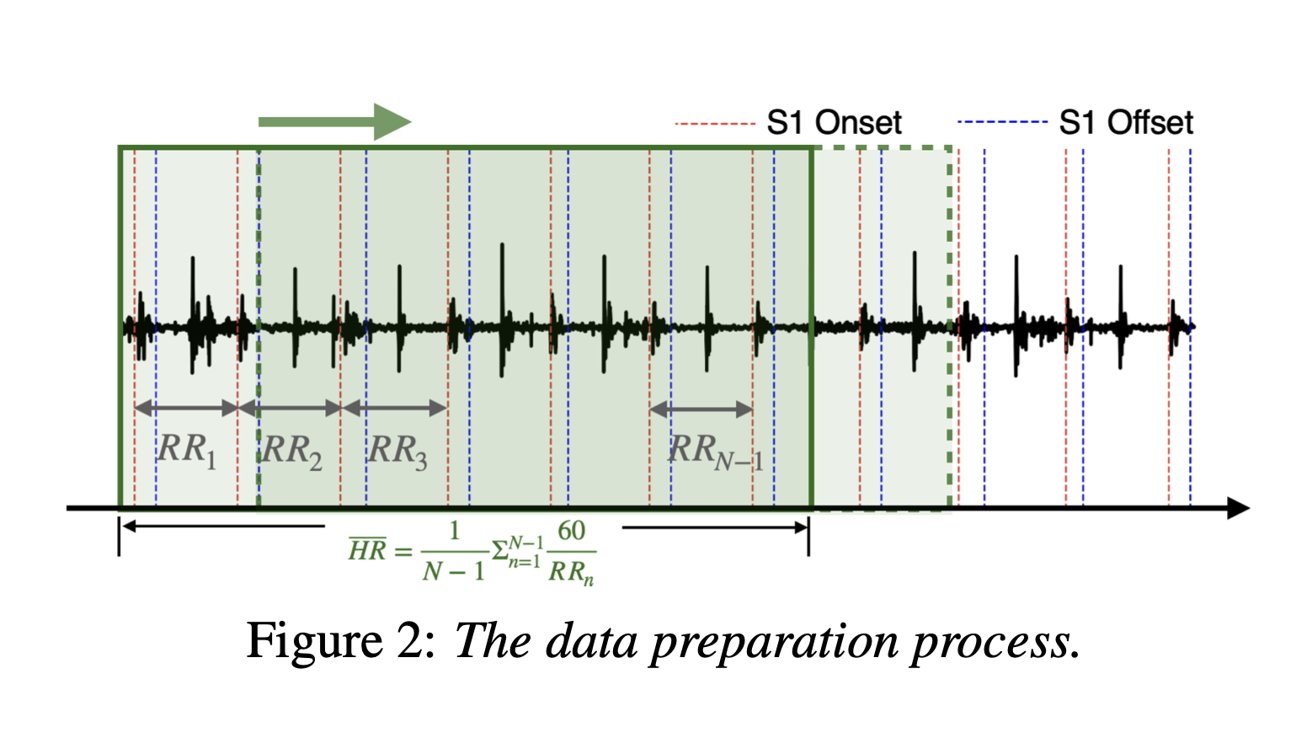

Apple 使用大约 20 小时的心声图音频文件进行了测试。图片来源: 苹果人类注释者在心音图音频文件中注释了心脏杂音,并将文件分成每秒移动一次的 5 秒片段。该过程总共产生了 23,381 个心音片段,旨在转换为心率测量。

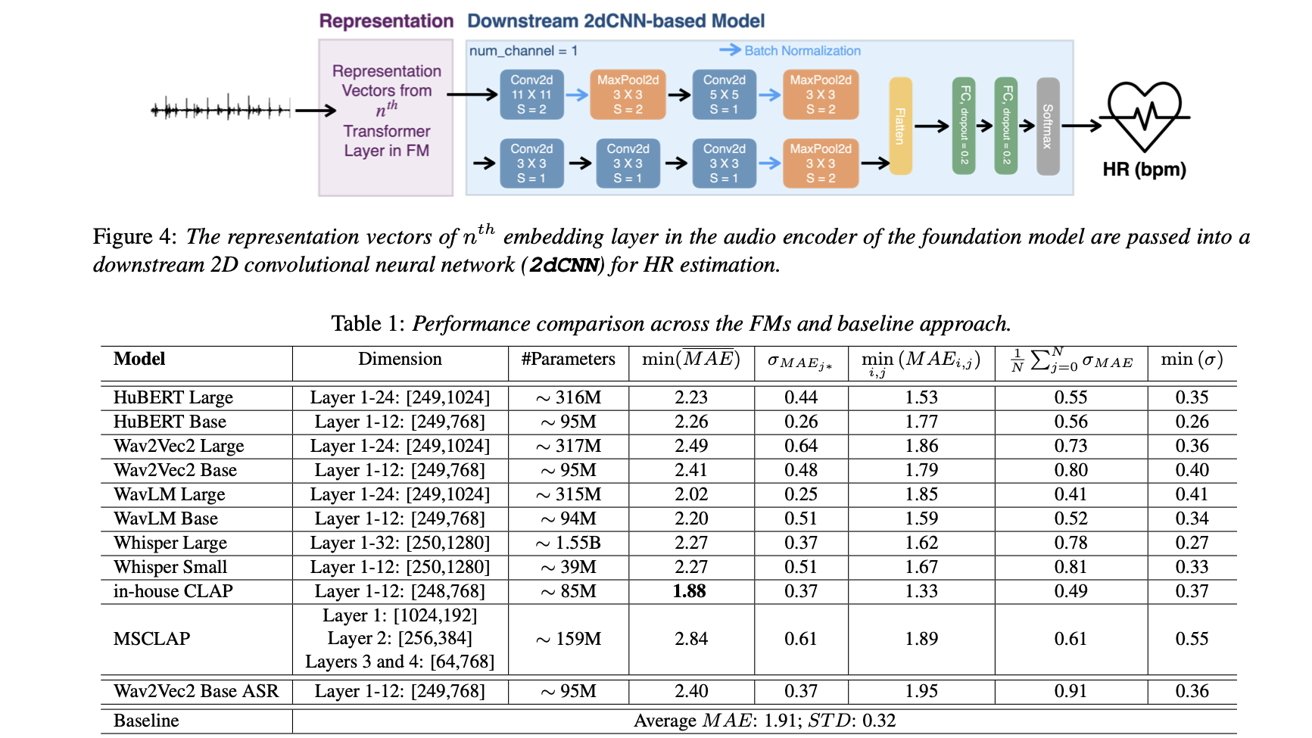

该公司的研究解释说,其内部 CLAP 模型在这项任务中比现有模型表现更好。“我们观察到,内部 CLAP 模型的音频编码器的表示在各种数据分片中实现了最低的平均绝对误差 (MAE),优于使用标准声学特征训练的基线模型。”

与 Whisper、wav2vec2 和 wavLM 不同,该公司也以相同的方式对其进行了测试,其内部 CLAP 模型是使用音频数据进行训练的,这些数据不仅仅包含录制的语音。该研究称,不同的训练数据“可能会增强其捕获与心音相关的非语音特征的能力,从而有助于提高其有效性”。

Apple 的内部 CLAP 模型优于其他基础模型。图片来源: 苹果

Apple 的内部 CLAP 模型优于其他基础模型。图片来源: 苹果Apple 的研究人员表示,为语音处理创建的基础模型“可以有效地适应听诊和生命体征估计,为一些传统方法提供了一种强大而有效的替代方案。该公司的结果表明,较大的基础模型在确定心率方面并不总是表现得更好。

根据这项研究,对基础模型进行额外的微调可能会带来更好的心率估计。该公司的研究人员看到了“心肺音的病理分析”的潜在应用,这可能有助于更准确地检测心律失常和杂音等异常情况。

至于在设备中的使用,Apple 可能会将此技术整合到未来的 AirPods 型号鉴于公司的利益在与健康相关的功能中。这AirPods Pro 2 系列,例如,支持一组听力健康功能,并通过内置麦克风提供主动降噪 (ANC)。

来自2024 年 12 月表明 Apple 正在寻求实现心脏和温度传感器等。该公司可能会使用 AirPods 的现有麦克风和新传感器来更准确地确定心率。