苹果仍在持续研发让Siri能够“看懂”屏幕上应用的方法,最新论文详细介绍了他们正在开发一款可在iPhone本地运行的Ferret版本。

苹果让Siri赶上其他智能手机AI系统的步伐正在逐步加速。虽然短期内推出全新、更具上下文理解能力的Siri尚未完全成熟,但苹果仍在为它的智能助手和Apple Intelligence规划未来的重大升级。

未来的方向似乎聚焦于苹果的核心优势:本地查询处理。

Ferret的进化之路

2023年,苹果联合康奈尔大学研究人员发布了开源多模态大模型“Ferret”。这款模型能够针对图像中的指定区域进行查询,例如识别照片中手绘框选区域的内容。

半年后,2024年4月,研究进一步升级推出了Ferret-UI版本,该模型可以理解用户界面元素。也就是说,它能够读取手机屏幕截图,识别并理解界面上的关键元素,甚至可能与已打开的应用界面进行交互。

而在2026年2月发布的“Ferret-UI Lite”论文中,这一技术迎来自然进化,目标是解决之前版本的一个核心问题:依赖体量庞大的云端大语言模型(LLM),完全不适合设备端本地运行。

此前使用云端大模型有其道理,因为其强大的规划和推理能力能保证极佳的效果。但这意味着需要将数据发送到云端服务器,而注重隐私和安全的用户更希望数据完全在本地处理。

研究团队注意到,虽然GUI交互和多智能体系统已有进展,尤其在减少智能体与用户界面交互的工作量方面,但要在智能手机上本地完成全部工作仍然负担过重。

这直接促成了全新轻量版Ferret-UI的诞生。

更薄、更快、更强

Ferret-UI Lite是一款端到端的跨平台GUI智能体,支持移动端、网页端和桌面端系统。换言之,它能在iPhone等智能手机上轻松运行而不会过于吃力。

为了实现这一点,Ferret-UI Lite采用30亿参数规模,训练数据结合真实GUI数据与合成数据。同时通过思维链推理、视觉工具使用以及强化学习大幅提升推理阶段的性能。

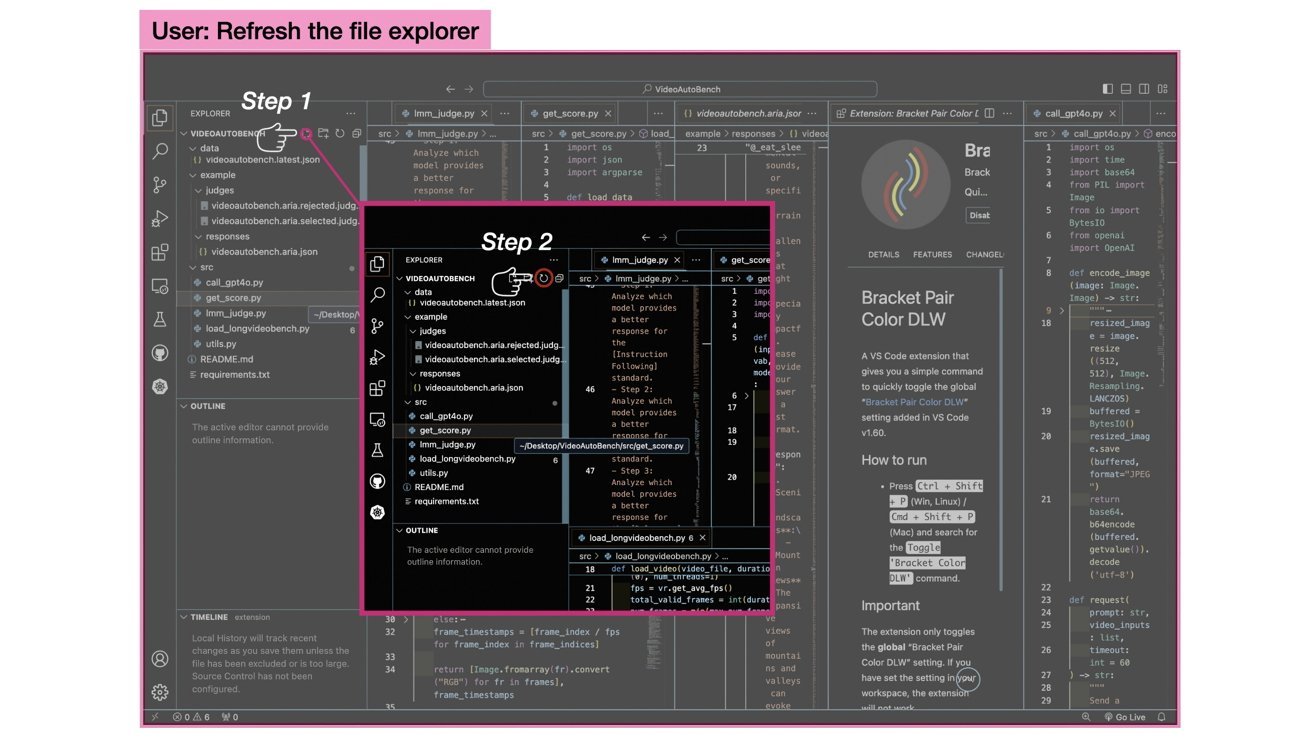

根据预测对屏幕图像进行裁剪以大幅减少需要分析的数据量(Ferret-UI Lite论文示意图)

作为本地处理查询的典型优化示例,Ferret-UI Lite加入了“放大聚焦”机制来分析UI图像。模型首先做出初步预测,然后根据预测结果对图像相应区域进行裁剪。

裁剪后需要处理的图像区域大幅缩小,模型就能更专注地分析该区域内的信息,从而显著提升预测的精准度。

研究人员认为,这一机制非常接近人类在观察细节时会凑近仔细查看的行为。

极具前景的研究成果

虽然Ferret-UI Lite并非革命性突破,但在与服务器级大模型智能体对比时,其表现依然非常亮眼。团队甚至表示,在某些场景下它能超越参数更大的模型。

在ScreenSpot-Pro GUI定位基准测试中,该模型准确率达到53.3%,比70亿参数的UI-TARS-1.5高出超过15%。

当然,也并非完美无缺。在GUI导航任务中,Ferret-UI Lite的表现相比更大模型仍有差距,但整体水平与UI-TARS-1.5相当。

论文最终总结认为,此次实验“验证了这些策略在小型智能体上的有效性”,同时也指出了局限性。缩小GUI智能体规模既有巨大潜力,也充满挑战,研究团队希望这项工作能为未来相关研究提供重要参考。