苹果公司公开了其隐私与机器学习研讨会的演讲视频,展示该公司如何在运用AI处理数据时保护用户隐私。

苹果始终强调自己是一家注重隐私的企业,这一理念也贯穿于其人工智能和机器学习研发中。在举办”机器学习隐私保护”研讨会后,苹果分享了活动细节并公布了相关研究成果。

这场为期两天的”隐私保护机器学习(PPML)”研讨会于2025年初举行,汇集了苹果内外的研究人员共同探讨PPML议题。

与会者来自多所高校,以及谷歌研究院、谷歌DeepMind和微软研究院等机构。

研讨会聚焦四大领域:隐私学习与统计、攻击与安全、差分隐私基础,以及基础模型与隐私。

苹果表示,这些演讲和讨论旨在探索隐私保护、安全技术与人工智能发展的交叉领域,并就构建具备隐私保护功能的AI系统所面临的挑战展开探讨。

苹果指出,这些隐私讨论旨在”在保障用户隐私的同时促进技术创新”。

深度思考

苹果公布的研讨会成果涵盖了AI与隐私领域的多个研究方向。

会议多次讨论如何更直接地保护用户,例如开发具有隐私意识的对话代理。针对恶意行为者可能利用聊天机器人上下文理解能力的风险,研究人员提出了通过限制数据访问来防泄漏的AirGapAgent方案。

研究显示,当Gemini Ultra代理遭遇”单次查询上下文劫持攻击”时,其用户数据保护率从94%降至45%,而AirGapAgent仍保持97%的保护率。

类似研究《针对大语言模型的用户推理攻击》探讨了如何判断LLM响应是否使用用户数据微调,以及相应的防御策略。

另一项研究介绍了名为Wally的可扩展隐私搜索系统,支持高效的语义和关键词查询。该系统通过优化处理密集型加密操作,在大规模应用时表现优于现有方案。

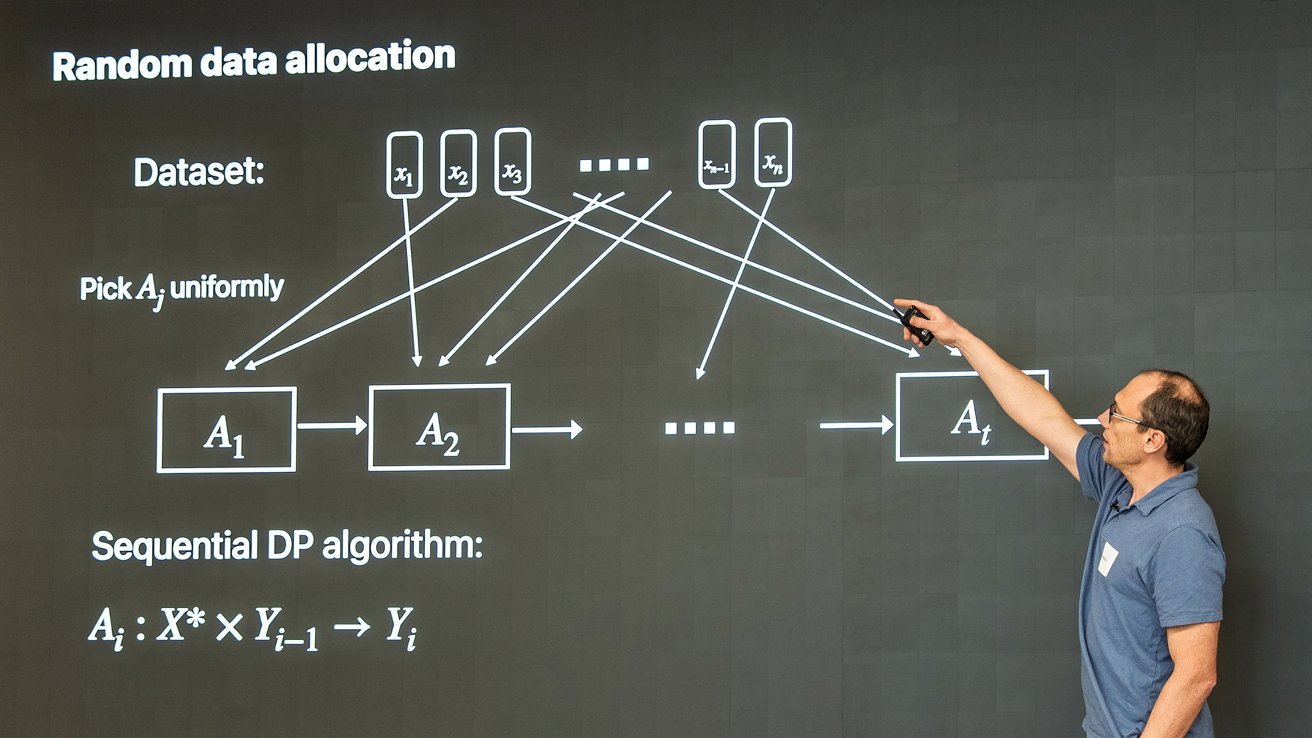

其他演讲包括《差分隐私全对距离近似的广义二叉树机制》《差分隐私机器学习的近乎严格黑盒审计》和《大象不会遗忘:具有隐私预算状态连续性的差分隐私》等。

隐私与创新的平衡

这并非苹果首次举办机器学习主题研讨会。2024年其曾举办”以人为本的机器学习”研讨会,并于2025年7月公开相关演讲。

在机器学习行业持续面临质疑的背景下,这场聚焦隐私的研讨会成果发布显得尤为及时。

7月,苹果不得不强调其AI训练符合伦理规范,承诺未经许可不会抓取网络数据。

然而8月曝光的AI初创公司Perplexity却通过备用浏览器代理绕过robots.txt限制进行网页抓取。

苹果自身的机器学习进展似乎也面临挑战,备受期待的Apple Intelligence版Siri升级一再延期。

通过持续强调隐私至上理念并付诸实践,苹果至少展现了其在伦理标准方面相较同行的优势。

尽管这些努力来得有些迟。