有报道称,自2021年以来,数十名十几岁的男孩在成为勒索者的受害者后自杀身亡,苹果公司正依靠其通信安全帮助保护潜在受害者的功能,但一些批评者表示这还不够。

被勒索的青少年被骗子掠夺的案件数量正在上升,这些骗子要么欺骗受害者提供露骨的图像,要么只是利用人工智能制作虚假图像进行勒索。结果往往是悲剧性的。

来自《华尔街日报》有分析了一个数字这些年轻的受害者最终结束了自己的生命,而不是面对自己公开的真实或伪造的露骨照片的羞辱。这些内容被称为儿童性虐待材料,或CSAM。

简介中提到了青少年对苹果消息传递是问题的一部分。

《华尔街日报》的文章包括一个关于高中啦啦队教练Shannon Heacock和她16岁的儿子Elijah的故事。以利亚像往常一样给妈妈发了第二天的活动短信,然后上床睡觉了。

几个小时后,希科克被女儿吵醒了。以利亚在洗衣房被发现,身上有枪伤,正在流血。他第二天早上去世了。

他和文章中介绍的另外两名青少年是犯罪分子的受害者,他们在社交网络上与青少年建立联系,经常冒充少女。经过一段时间的社交聊天以获得信任后,勒索者发送了他们冒充的“女孩”的虚假露骨照片,并要求受害者提供类似的照片作为回报。

然后,他们勒索受害者,要求以礼品卡、电汇甚至加密货币的形式付款,不要公开分享这些图像。

要求立即付款,使受害者面临支付勒索的时间压力——他们通常无法做到这一点——或者面临家庭、学校和公开羞辱。

面对他们认为不可能的选择,这些青少年可能会自杀以逃避勒索的压力。这种骗局被称为“sextortion”,已经夺走或毁掉了许多年轻人的生命。

CSAM检测和苹果目前的努力

随着社交网络的兴起,性侵犯案件激增。总部位于美国的国家失踪和受剥削儿童中心去年发布了一项研究,显示2022年至2023年间报告的性扭曲病例增加了2.5倍。

NCMEC在2022年报告了10731起性侵犯案件,在2023年报告了26718起,其中大多数是年轻男性。该组织建议青少年的父母先发制人地讨论网络勒索威胁的可能性,以尽量减少勒索者威胁的影响。

当这个问题在2021年首次广泛传播时,苹果公司宣布了一套工具,将用于检测未成年用户账户上可能存在的CSAM图像。

这包括以下功能iMessage, 苹果智能语音助手和搜索,利用扫描机制苹果云照片与已知的CSAM图像数据库进行哈希运算。

其中还包括一种机制,用户可以标记不合适的消息或图像,并向苹果报告发件人。图像扫描仅适用于iCloud照片用户,不适用于本地存储的图像。

在隐私倡导者、儿童安全组织和政府的强烈抗议下,苹果放弃了根据CSAM数据库扫描iCloud照片的计划。相反,它现在依赖于通信安全功能和成人对儿童帐户的控制,以保护其用户。

苹果公司用户隐私和儿童安全总监Erik Neuenschwander表示:“扫描每个用户私人存储的iCloud数据将为数据窃贼发现和利用创造新的威胁载体。”。“这也可能带来意想不到的后果。”

他继续说道:“例如,扫描一种类型的内容为批量监控打开了大门,并可能引发跨内容类型搜索其他加密消息系统的愿望。”。包括美国在内的一些国家已经向苹果施压,要求其允许此类监控。

Neuenschwander补充道:“几年前,我们决定不继续采用混合客户端-服务器方法对iCloud照片进行CSAM检测。”。“我们得出的结论是,在不最终危及用户安全和隐私的情况下,实际上是不可能实施的。”

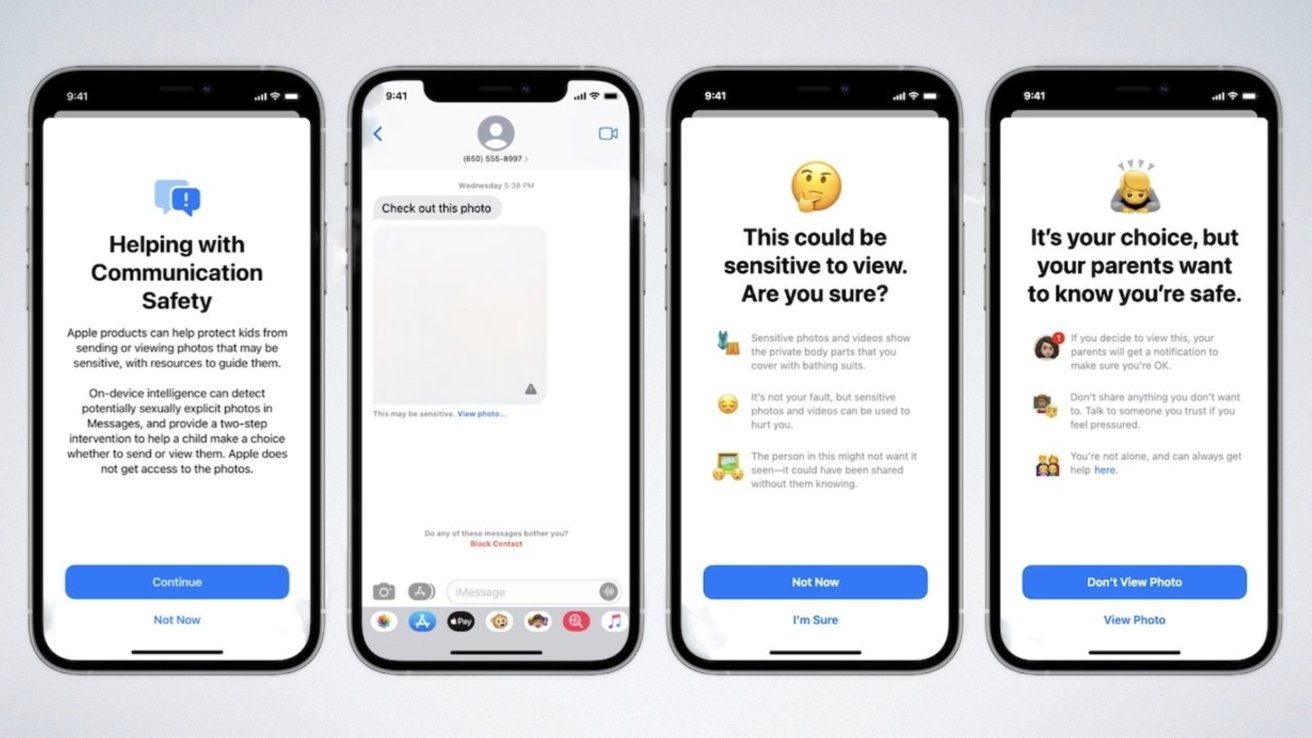

苹果现在使用通信安全来帮助保护儿童用户。

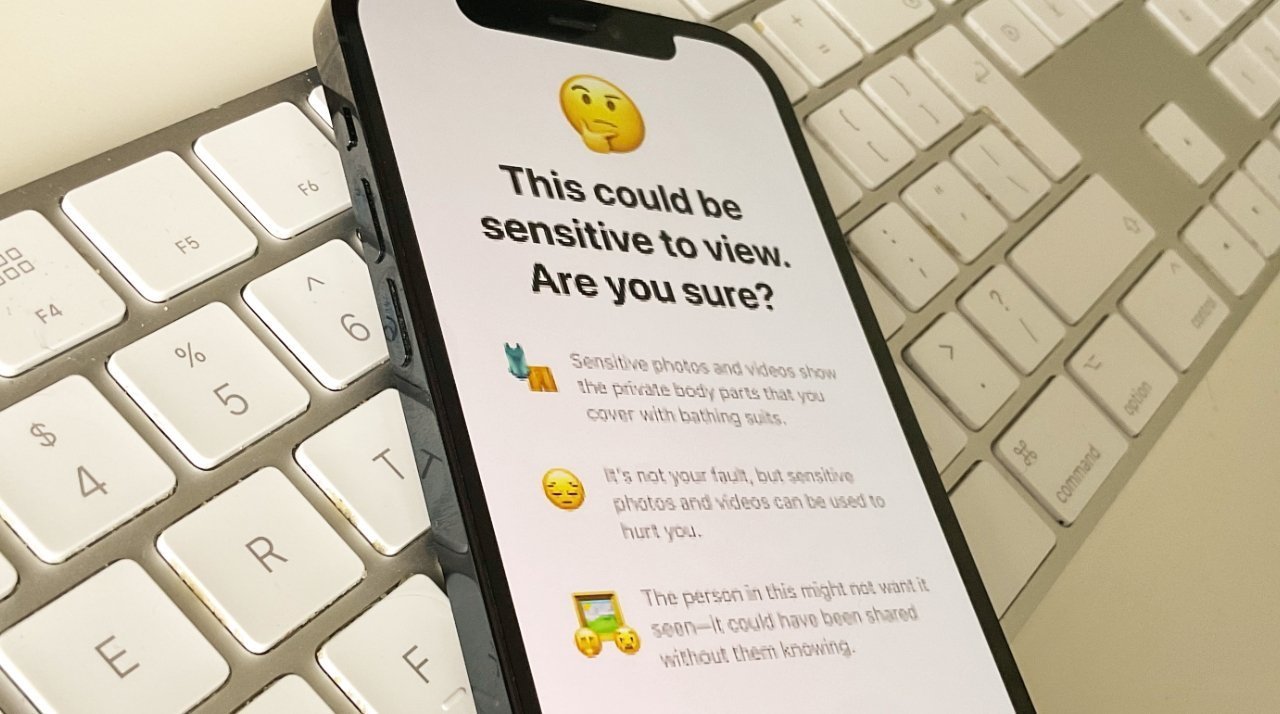

苹果现在使用通信安全来帮助保护儿童用户。相反,苹果公司选择加强家长对儿童账户的控制,这些账户可以为18岁以下的儿童和青少年设置。这包括允许父母打开一项功能,检测儿童帐户中发送和接收的照片中的裸体,并在孩子看到之前自动模糊图像。

如果儿童帐户用户收到或打算发送包含裸体的图像,儿童将获得有用的资源。他们会放心,如果他们不想看这张照片,也没关系。

孩子还可以选择向他们信任的人发送消息寻求帮助。

父母会不如果系统检测到消息包含裸体,因为苹果公司担心过早通知父母可能会给孩子带来风险,包括身体暴力或虐待的威胁。

然而,孩子会被警告父母将如果他们选择打开包含裸体的蒙面图像,或者在警告后发送包含裸体的图像,系统会通知他们。

尽管一些团体呼吁苹果和其他科技公司采取进一步措施,但该公司独特地试图在用户隐私和防止伤害之间取得平衡。苹果公司继续研究提高通信安全的方法。