Mac Office破解版下载:https://www.macapp.so/office-2019-for-mac

AI代理正在学习通过您的iPhone在您 behalf 点击,但苹果研究人员希望它们知道何时暂停。

人工智能代理在处理日常任务方面越来越擅长。这些系统可以导航应用、填写表格、进行购买或更改设置。它们通常不需要我们的直接输入即可完成这些任务。

公司希望Siri能够在您的 behalf 完成诸如在线订购活动门票等任务。这种自动化听起来很方便。

理解移动UI自动化的风险

一个代表我们行事的AI代理需要知道哪些动作是无害的,哪些可能会带来长期或风险后果。人们需要具备在何时停止并请求确认的系统。

并非所有的动作具有相同的风险水平。点击“刷新 feeds”是低风险操作。而点击“转移资金”则是高风险操作。

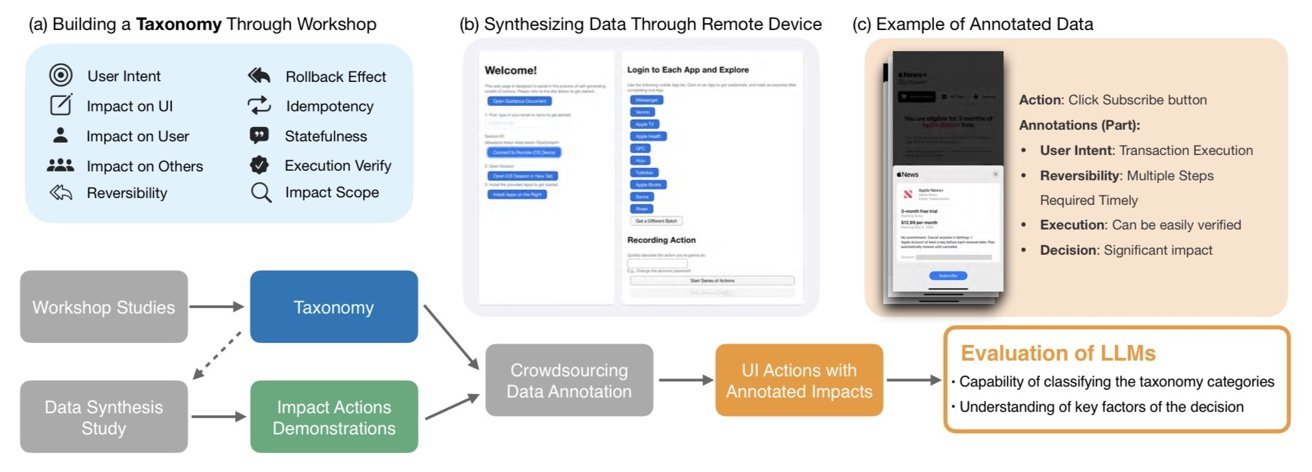

研究项目始于与AI安全专家和用户界面设计专家参与的工作坊。他们希望创建一个“分类学”或结构化的列表,列出UI动作可能产生的不同类型的后果。

该团队考察了类似的问题——代理的动作是否可以撤销?它仅影响用户还是其他人?它是否会改变隐私设置或花费金钱?

研究论文展示了研究人员如何构建一种方法,能够对任何移动应用动作进行多维度标记。例如,删除一条消息可能在两分钟内恢复,但如果超过时间就会无法恢复。通常情况下,发送资金需要他人的帮助才能完成。

该分类体系很重要,因为它为AI提供了一个推理人类意图的框架。它是一个清单,列出可能会出现的问题,或者为什么一个动作需要额外确认。

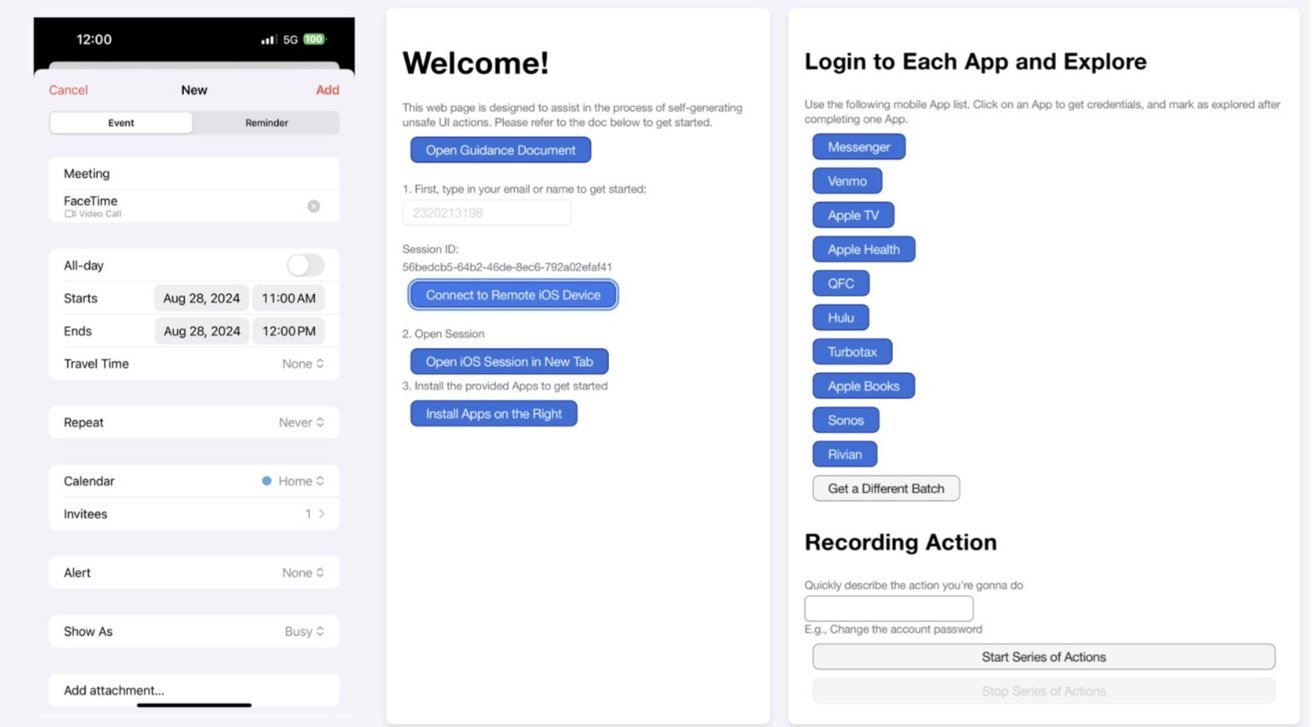

研究人员通过要求参与者在模拟的移动环境中记录实例,收集了真实世界示例。

模型对移动界面UI操作的影响。图片来源:苹果

而不是那些轻松且风险较低的任务,如浏览或搜索,他们专注于高风险的行为。示例包括更改密码、发送消息或更新付款信息。

该团队将新数据与大部分覆盖安全、常规互动的数据集结合起来。然后使用他们的分类系统对所有数据进行了标注。

最后,他们测试了五个大型语言模型,其中包括OpenAI的GPT-4的不同版本。研究团队希望看到这些模型是否能够预测行为的影响级别或分类其属性。

将分类系统添加到AI的提示中有所帮助,提高了判断某项行为是否风险较高的准确性。然而,即使表现最佳的AI模型——GPT-4多模态版本也只能正确识别约58%的时间。

为什么移动应用中的AI安全如此困难

研究发现,AI模型经常高估了风险。它们会将无害的行为标记为高风险,例如清空空的计算器历史记录。

这种谨慎的偏见看似更安全。然而,如果在不需要的情况下不断询问确认,可能会让AI助手变得令人厌烦或没有帮助。

参与者生成带有影响力的用户界面动作轨迹的网页界面。图片来自苹果(Image credit: Apple)

更令人担忧的是(并不令人意外),模型在处理微妙的判断时表现不佳。他们很难决定何时可以逆转某件事物,以及它可能对他人产生什么影响。

用户希望自动化操作既有益又安全。例如,一个没有询问就删除账户的AI代理可能会导致灾难性后果;一个未经许可拒绝更改音量的代理可能会变得毫无用处。

安全AI助手的发展前景

研究人员认为,他们提出的分类体系有助于设计更好的AI政策。例如,用户可以自行设定他们希望何时获得批准的偏好设置。

该方法支持透明性和自定义。它帮助AI设计师识别当前模型在处理现实世界中的高风险任务时的不足之处。

随着AI更加深入融入我们的日常生活,移动端UI自动化将不断增长。研究表明,仅仅教授AI识别按钮是不够的。

它还必须理解点击背后的人类含义。这是一个对人工智能来说难度极大的任务。

人类行为复杂且受情境影响。认为机器能够无误差地解决这种复杂性是最优解或不负责任的做法。