OpenAI最新发布的gpt-oss-20b模型让您的Mac无需订阅、无需联网即可运行类ChatGPT的AI工具。以下是详细部署教程。

8月5日,OpenAI发布了多年来首个开源权重的大语言模型,使Mac用户能够离线运行类ChatGPT工具。通过简单配置,多数Apple Silicon芯片的Mac现在都能处理高级AI任务而无需订阅或网络连接。

过去在Mac上运行强大AI模型需要购买云服务或配置复杂服务器软件。全新的gpt-oss-20b和gpt-oss-120b模型改变了这一现状。

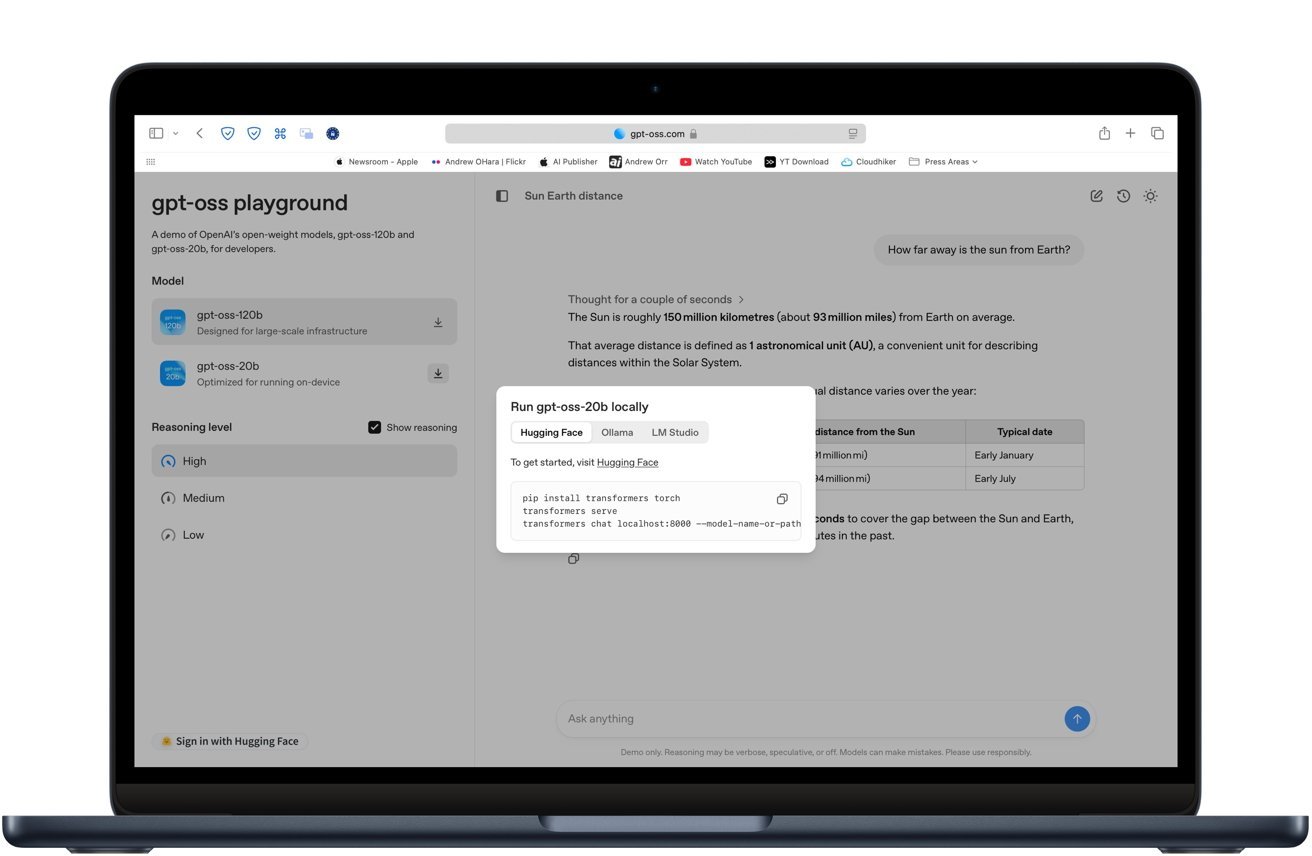

这些模型提供可下载的权重文件,兼容LM Studio和Ollama等主流本地AI工具。

您可以在gpt-oss.com网站直接体验模型演示,无需下载即可测试其写作、编程和问答能力。

系统要求

建议至少配备M2芯片和16GB内存,配置越高越好。若使用M1处理器,推荐Max或Ultra版本。Mac Studio因其卓越散热性能成为理想选择。

在我们的M3芯片MacBook Air测试中,模型运行稍有迟滞,设备发热明显。

这类似于在Mac上玩游戏——可行但要求较高。

您需要准备以下工具之一:

这些应用可自动处理模型下载、设置和兼容性检查。

Ollama使用教程

Ollama是一款轻量级工具,支持通过命令行以最小配置运行本地AI模型。

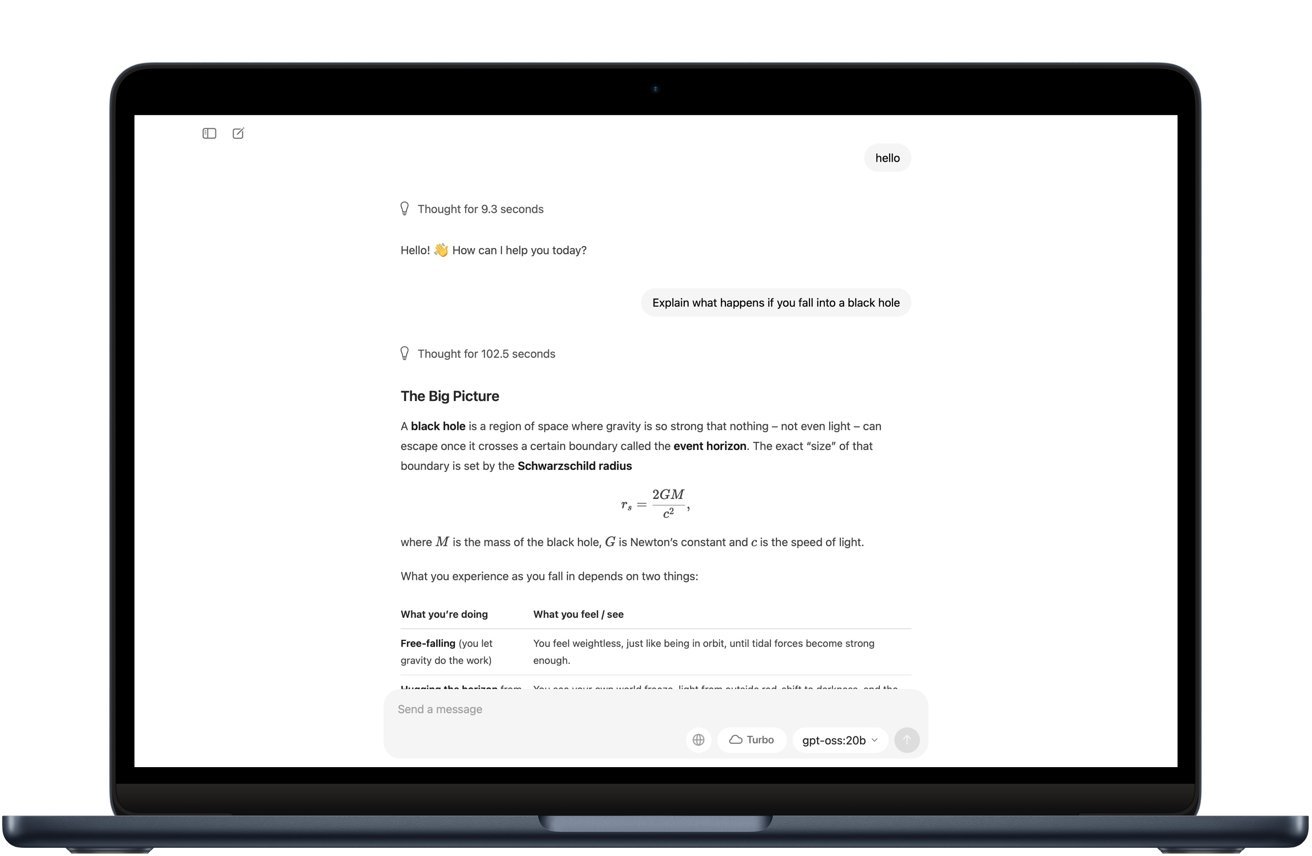

其交互方式类似ChatGPT,但所有计算均在本地完成。测试中模型下载约12GB,下载时长取决于网络速度。

在16GB内存的M3芯片MacBook Air上,响应速度明显慢于云端GPT-4o,但完全离线运行的特性颇具价值。

性能与限制

200亿参数的模型已压缩为4-bit格式,可在16GB内存的Mac上流畅运行多数任务。

虽然复杂任务处理速度不及云端GPT-4o,但已能满足大部分个人和开发需求。更大的120b模型需要60-80GB内存,仅适合高端工作站。

本地运行的优势

本地推理保障数据隐私,避免API订阅费用,并通过消除网络延迟提升响应速度。

基于Apache 2.0许可,用户可对模型进行微调以适应特定工作流程,这种灵活性支持专业化项目定制。

gpt-oss-20b是追求完全离线运行的理想选择,虽然响应速度较慢且复杂答案需要人工润色,但对于日常写作、基础编程和研究工作表现良好。

优化建议

使用量化版本(如8-bit或4-bit整型)可大幅降低内存占用同时保持精度。OpenAI的gpt-oss模型采用MXFP4格式,使20b模型能在16GB内存Mac上运行。

若内存不足16GB,建议选择30-70亿参数的小模型。运行前关闭内存密集型应用,并启用MLX或Metal加速以提升性能。

通过正确配置,您的Mac可成为保护数据安全的离线AI工作站。虽然无法完全替代高端云模型,但在重视隐私和控制的场景下表现出色。