iPhone 可能很快将获得对模型上下文协议(Model Context Protocol)的支持,此举有望让第三方 AI 工具在苹果产品上比以往任何时候都更加实用。

本周一,苹果发布了首个 iOS 26.1 开发者测试版。该软件中的代码表明,苹果正在努力实现对模型上下文协议(简称 MCP)的支持。

简而言之,MCP 使得 AI 系统能够通过一个通用协议来访问并与其所需的数据交互,而无需为每个数据源依赖定制化的实现方式。

正如我们此前所述,模型上下文协议由 Anthropic 提出,但此后已被 OpenAI 和 Google 等领先的 AI 公司采用。基于首个 iOS 26.1 开发者测试版,苹果即将成为最新一家实现 MCP 支持的科技巨头。

App Intents、Siri 与 MCP

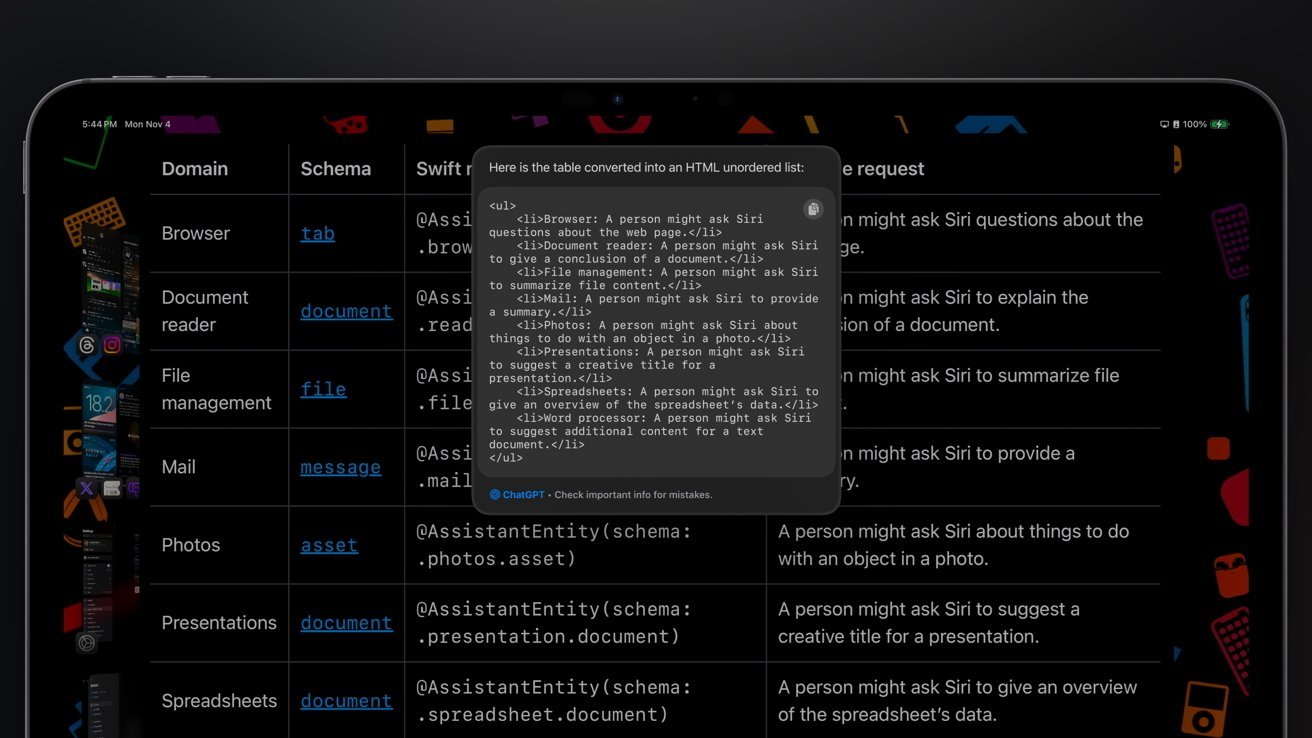

通过引入对模型上下文协议的支持,苹果将使得第三方 AI 系统能够与 iPhone、iPad 和 Mac 应用程序交互。至于其工作原理,苹果的 App Intents 系统提供了有价值的见解。

借助 App Intents,Siri 能够在应用程序中执行操作,同样的功能也提供给了苹果的快捷指令(Shortcuts)应用。苹果一直在努力改进该系统,而这些改进预计将带来期待已久的 Siri 重大革新。

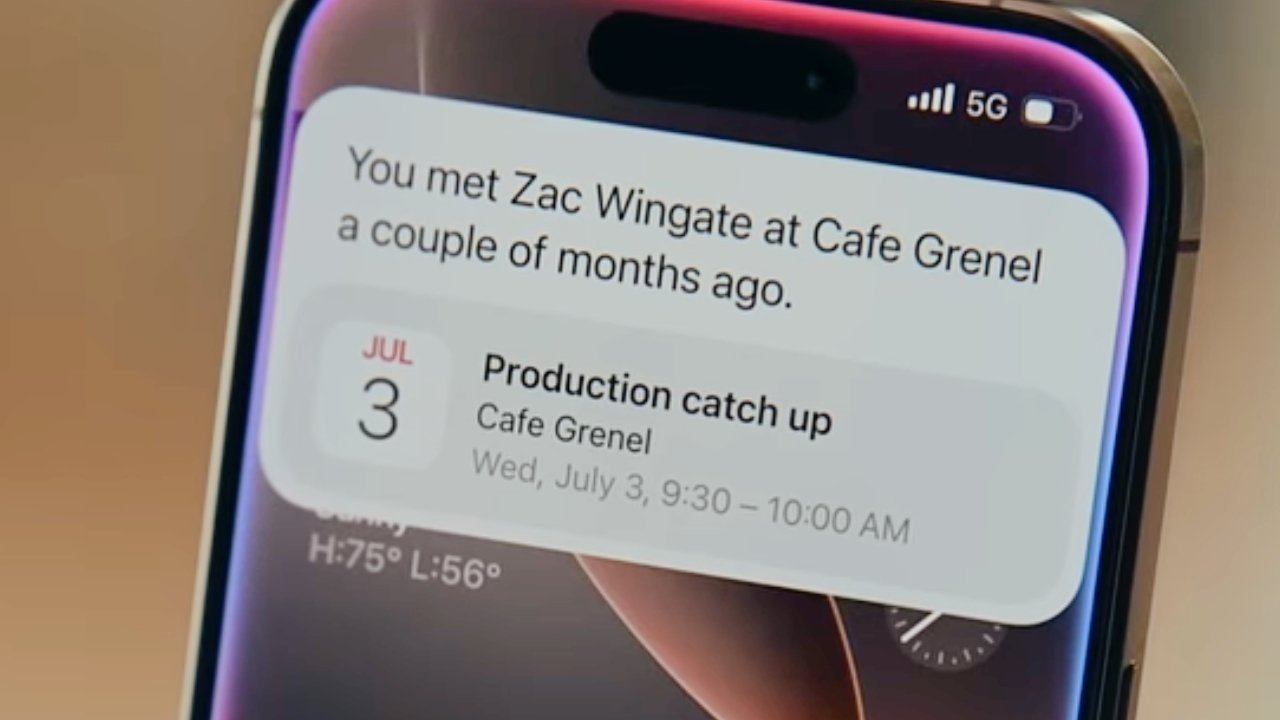

根据苹果发布的开发者文档,开发人员可以测试 app intent 系统,以使屏幕上的内容可供 Siri 和 Apple Intelligence 使用。简单来说,这意味着用户将能够将屏幕上任何活跃的内容发送给 AI 进行解析。

有朝一日,Siri 或许能够回答关于网页内容的问题,或者编辑照片并根据用户的要求发送它们。该助手或许还能获得对 Instagram 帖子应用评论,或将商品添加到在线购物车的能力,所有这些都无需触摸屏幕。

如果苹果按计划实施模型上下文协议,它可以让第三方工具以同样的方式与应用程序交互。理论上,这意味着用户可以要求 OpenAI 的 ChatGPT 在 iPhone、iPad 和 Mac 上执行应用内操作。

然而,还有另一个潜在的应用,因为 MCP 也可能让 Siri 能够从网络收集更多数据。先前的传言表明,Siri 的搜索功能将主要由苹果自己的模型处理。

苹果革新 Siri 的计划

根据 2025 年 9 月的传闻,苹果计划推出一项由苹果基础模型(Apple Foundation Models)支持的网页搜索功能。据称,该功能将能够调用 Google Gemini 来增强 Siri 收集和汇总信息的能力。

Siri 预计将在 2026 年初获得基于 app intents 的升级。

据传,新版 Siri 将拥有三个核心组件:一个规划器(planner)、一个搜索操作器(search operator)和一个汇总器(summarizer)。苹果的基础模型将充当规划器和搜索操作器,因为这涉及到处理设备上的个人数据。

从网络获取数据并进行整理可能由 Google 模型负责。据报道,Google 提供了一个在私有云计算(Private Cloud Compute)中运行的 Gemini 版本,帮助充当网络汇总工具。

理论上,iOS 对 MCP 的支持可能让 Google Gemini 在 iPhone 上做的远不止提供搜索结果。跨第三方应用程序的应用内操作显然是一种可能。

苹果此前曾承诺 Siri 将能够执行高级的应用内任务,但计划的升级已被推迟。让第三方工具做同样的事情将被证明是一种权宜之计,同时它也将给消费者更大的选择自由。

与此同时,MCP 可能让 Siri 无需依赖 Google Gemini 或其他 AI 产品即可从网络获取信息。这是因为 MCP 是一种协议,使得 AI 系统能够从各种来源访问数据。

MCP 可能使得 Siri 或第三方 AI 能够在 iOS 上执行高级的应用内操作。

目前,Siri 在需要信息时只能执行基本的隐私保护网络搜索。更高级的任务会在用户同意的情况下交给 ChatGPT 处理。

最终,苹果似乎更倾向于与 AI 公司合作,而不是创建一个仿制产品。这种方法可以说是独特的,它可能在为用户提供多种 AI 选择的同时,促进有意义的发展。

革新后的 Siri 预计将于 2025 年春季首次亮相,很可能会随 iOS 26.4 更新一同推出。